明星带货, 马斯克投资带你飞? 这些声音、视频都是假的!

“仅凭声音或视频内容即可确认对方真实身份?”

P图容易,模仿口音难,只要口音是本人,就应该是本人。

流言分析

这种说法已不符合当下科技发展情况。

目前AI语音合成、克隆技术已成熟,几秒语音即可生成高仿真音色,甚至还能实现接近实时交流的效果。因此,“眼见已然难为实,耳听也有可能虚”,为避免上当,需通过音画同步、对口型细节、二次验证等方法防范,避免轻信声音或视频内容。

很多动作片或科幻片,都出现过特工模仿反派语音,欺骗敌人胜利完成任务的情节,而今天这已成为现实(只不过是反的……)——骗子开始用这类技术来骗钱了!

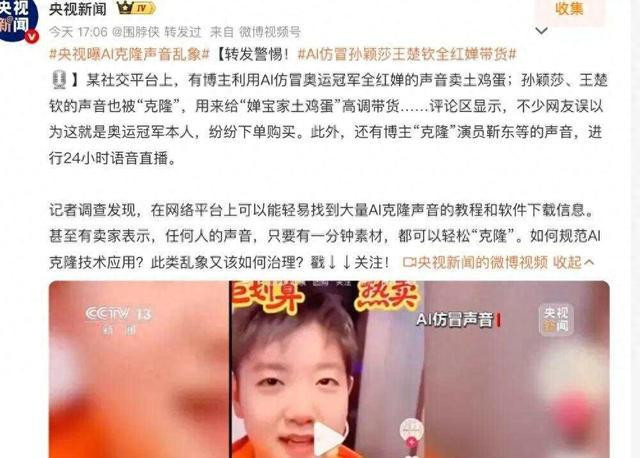

比如央视新闻前几天这几个案例,就让人非常不安。

除了假装“奥运冠军”带货,还有人做了个“马斯克”要带你一起投资,走上人生巅峰。

近两年来,各种利用AI技术进行名人明星仿冒和声音克隆的诈骗案例,冒出一波又一波。那么这是怎么做到的,我们又该如何防范呢?今天就来聊一聊(文末有防骗指南)。

合成语音对AI不是难事

自2022年ChatGPT发布后,AI才开始慢慢走进大众的生活,它既给我们的生活带来很多方便,在心怀叵测的人的手中,又会带来潜在的风险和负面影响。现实就是,虽然目前的AI还远远不能像很多人担心的那样,给人类带来灭顶之灾,但它却已经能能轻而易举地欺骗人类了。其中,语音识别、语音合成和语音克隆,就是一个典型方向。

最近两年以来,声音克隆的技术模型经过多方、多次迭代升级,在部分开源模型中,几秒钟语音就能生成高度相似的音色,再利用文本转语音技术,就可以通过文本朗读,任意编造“某个人”说话的内容。

而名人明星们,他们有大量的声音、视频片段内容,流传在网络,而越大量的训练素材,意味着AI克隆出的仿真程度越高。老百姓们面对出假“全红婵”、假“孙颖莎”,很难不中招。

更重要的是,这些技术模型很大一部分是开源的,虽然这方便了技术交流促进了技术进步,但这也意味着“作案工具”唾手可得了。在此基础上,已经有了各种可以直接使用的剪辑APP、网站应用,某些教程甚至宣称“30秒学会”。

这样就极大地降低了使用门槛和成本,使得造假合成的音频视频普及度日益提升。

为什么声音克隆仿真度可以这么高?

那么,为什么声音能被模仿得如此逼真呢?(如对技术内容不感兴趣可以直接拉到底看最后的防骗指南)。高中物理课上教过,咱们说话的声音本质上是一种时序信号,或者说是空气分子震动产生的波。

你可以简单理解成,每个人的声音都可以分解为不同频率波的叠加,这些频率分布特征就是声纹的重要基础。

被麦克风采样,输入后,声音变成一串离散数据点(时间序列):x(t)→[x1,x2,x3,…,xn]

每个点就是某一时刻空气压力的数值,形成波形。声音的这种数学上的一维结构非常直观,也为算法处理提供了很多便利性。

你可以把它想象成一条连续的曲线,许多经典的信号处理技术,如傅里叶变换(FourierTransform),能够非常高效地将这个时域信号分解成不同频率的正弦波和余弦波的叠加。这等于将声音的“配方”给解构了出来,让算法能清晰地“看到”声音的频率组成(音高、音色等),这是声音分析一个巨大的优势。

相比而言,图像和文本的数学化更偏向“抽象”,更复杂,影响因素更多元。比如图像,虽然像素值本身是数字,但要理解“这是一只猫”,算法需要从像素矩阵中学习和抽象出边缘、角点、纹理,再到“猫的耳朵”、“猫的眼睛”等更高层次的概念。这个过程是层层抽象的。而文本的抽象就更加极致。算法必须从零开始学习整个语言体系中符号(词语)所代表的复杂含义和它们之间的关系。而且,和复杂的人脸相比,声音变化维度有限(主要是频率、音高、节奏),模型更容易捕捉到核心特征。

重中之重,提高警惕

从前文大家可以看到,声音克隆技术既成熟又容易获得,这也意味着我们更容易遇到这类骗局。善良的朋友们,一定能够要提高警惕,下面就教大家一些辨别的方法。

看音画同步:如果一个视频,背景声音听起来像是“某个人”的讲话,但画面完全不同步,或者没有这个人的正脸,嘴巴没有跟着动,那咱们要警惕是否是语音合成,或者移花接木。

对口型细节:就算有某个人正脸讲话的视频,还需要观察口型细节是否自然。因为目前还有种视频生成技术叫“对口型”,它可以让人的口型根据所配的音频内容“动”起来,而这项技术也在不断强化。所以,咱们还是要注意查看账号属性:是否是名人认证账号,是否是平台认证的可靠媒体。以及视频节目是否标注了“疑似使用AI技术”。

如果确定或怀疑该视频是AI合成,而没有标注的话,可以向平台举报。

约二次验证:警惕“家人”来电或语音要求转账,更不要轻信陌生来电。

我们可以人肉设置“语音安全码”——比如和家人约定提问暗号来验证身份,就像有些网络支付或登录需要“二次验证”,咱们也要给自己的重要信息通讯加一把“锁”。

在AI能克隆任何人声音甚至伪造视频的时代,碰到涉及到我们财产安全、情感寄托、或者日常消费的决策,一定要擦亮双眼,看到“震惊体”的新闻或名人发言,先让消息“飞一会儿”,冷静观察下视频或内容是否涉及AI合成。碰到疑似AI内容而未加标注的内容,一定要向平台举报,以免假消息发酵扩散,使得网络环境污染扩大,影响我们正常的信息摄入。

照“谣”镜

AI走进大众生活以来,确实有一些人在利用AI作恶。但AI不是洪水猛兽,它的本质是一种工具。历史上,每一波技术革命——从蒸汽机到电力,再到互联网——都曾引发恐慌,也都伴随骗局与滥用。但最终,社会靠制度建设、科技进步和大众教育,大家总能找到与新工具相处的方式。声音克隆只是一个缩影,它提醒我们:技术的发展,有时候会超过监管的进步,而每个人都必须学会在不确定中保护自己。

文丨木木北京师范大学数学专业资深产品经理人工智能方向科普作者